由于高质量数据吃紧以及昂贵的数据中心建造成本,AI大模型的升级速度正在放缓,可能反过来拖累行业整体和数据中心建设的进展;同时,马斯克大举发力数据中心建设可能提升其他AI公司的扩张难度。

本文作者:李笑寅

来源:硬AI

全球数据中心正在面临放缓困境。

如火如荼的AI浪潮推升了数据中心的建设狂潮,但随着大模型对算力的要求每日俱增,数据中心升级的脚步似乎要跟不上持续强劲的AI需求了。

知名科技媒体The Information近日报道称,由于高质量数据吃紧以及昂贵的数据中心建造成本,AI大模型的升级速度正在放缓,可能反过来拖累行业整体和数据中心建设的进展。

与此同时,马斯克正大举发力数据中心建设,在“鲶鱼效应”(指引入强者后,激发弱者变强)下,一场更高难度的大型数据中心竞赛即将打响,数据中心的建设狂潮还能否延续?

“数据饥饿”限制大模型迭代速度

据OpenAI员工向The Information表示,GPT迭代放缓的原因之一是:可供大模型预训练所需的高质量文本和其他数据正在不断减少。

这些人士表示,在过去几年中, LLMs使用来自网站、书籍和其他来源的公开文本和其他数据进行预训练过程,而如今,这类数据几乎已被“榨干”。

据悉,在下一代旗舰模型“Orion”中,OpenAI虽然已经开始尝试在训练阶段引入AI生成数据,但同时又面临一个新问题,即Orion最终可能在某些方面与旧型号的大模型相似。

同时,数据中心昂贵的建造成本可能也难以支撑起迭代所需的庞大算力要求,OpenAI研究员Noam Brown在上个月的TEDAI会议上表示,开发更先进的模型在经济上可能并不可行。

“我们真的要训练花费数千亿美元或数万亿美元的模型吗?有时候,扩展(scaling laws)的范式也会崩溃。”

此外,由于大模型迭代升级对服务器集群规模的要求越来越高,所需的功率也呈倍数级提升,散热问题正越来越成为数据中心升级的一大阻碍。

马斯克发力AI,OpenAI等担心被“后来居上”

马斯克为xAI兑现“最大超算中心”的承诺的速度之快,已经向OpenAI等头部竞争对手成功制造了焦虑。

在今年7月“GenAI Summit SF 2024”人工智能峰会上,马斯克旗下的AI初创公司xAI宣布,计划在几个月内建成一个约10万H100芯片的数据中心,号称是“世界上最强大的AI训练集群”,旨在训练更强大的AI模型。

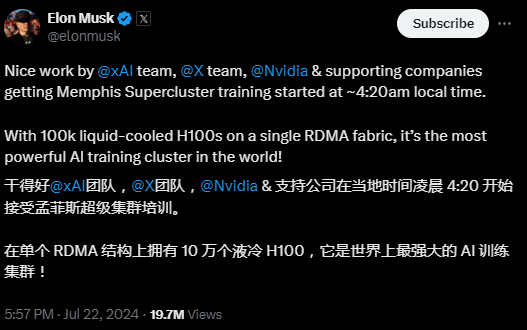

同月,马斯克社交平台“X”上宣布,xAI公司已开始在“Supercluster”上进行训练,该集群由10万个液冷英伟达的H100 GPU组成,在单个远程直接数据存取(RDMA)结构上运行。

马斯克的豪赌,基于“缩放定律”(scaling laws):数据中心规模越大、训练出来的大模型就越好。

据悉,“Supercluster”的集群规模是Meta等科技巨头已有数据中心规模的数倍。对比来看,OpenAI训练GPT4,需要用到25000块A100 GPU,仅为Supercluster的1/20。

并且,据英伟达方面向媒体透露,该数据中心仅用122天就建成,而根据其CEO黄仁勋的说法,这种这种规模的GPU集群通常需要三年的时间来规划和设计,还额外需要一年的时间才能投入使用。

尽管xAI的人工智能工具仍远远落后于OpenAI,但他构建数据中心的速度引起了Sam Altman的警惕。据一位知情人士向媒体透露,马斯克在X上官宣了Supercluster的建成后,Altman与微软的基础设施高管发生了争执,担心xAI的发展速度比微软快。

本文来自微信公众号“硬AI”,关注更多AI前沿资讯请移步这里

市场有风险,投资需谨慎。本文不构成个人投资建议,也未考虑到个别用户特殊的投资目标、财务状况或需要。用户应考虑本文中的任何意见、观点或结论是否符合其特定状况。据此投资,责任自负。